并行扩散架构突破极限,实现5分钟AI视频生成,「叫板」OpenAI与谷歌?

并行扩散架构突破极限,实现5分钟AI视频生成,「叫板」OpenAI与谷歌?近日,一家名为 CraftStory 的 AI 初创公司推出了 Model 2.0 视频生成系统,凭借可生成长达五分钟的富有表现力、可媲美专业水准、以人为中心的视频,破解了困扰 AI 视频生成行业长久以来的「视频时长」难题,引起热议,并被视为或将是 OpenAI 的 Sora 和 Google 的 Veo 的强有力竞争者。

近日,一家名为 CraftStory 的 AI 初创公司推出了 Model 2.0 视频生成系统,凭借可生成长达五分钟的富有表现力、可媲美专业水准、以人为中心的视频,破解了困扰 AI 视频生成行业长久以来的「视频时长」难题,引起热议,并被视为或将是 OpenAI 的 Sora 和 Google 的 Veo 的强有力竞争者。

在我们探讨今日关于Gemini 的新闻之前,需要提及今晨微软与英伟达宣布,将投资 Anthropic。该公司承诺在未明确时限内投入至少 300 亿美元租赁微软 Azure 云平台上配备英伟达芯片的服务器。至此,三大云服务商均已注资这家 OpenAI 的竞品,再次释放微软已从 ChatGPT 制造商分散投资的信号。

上个月 OpenAI 在发布 Sora 2 的同时将其作为独立应用发布,产品一经上线便登顶苹果应用商店榜首的现象级产品。本篇内容是对 Sora 2 的三位核心负责人的访谈:研发负责人 Bill Peebles、产品负责人 Rohan Sahai 以及工程与产品负责人 Thomas Dimson,Dimson 还参与过 Instagram 产品的搭建。

曾在英伟达身上错过2500亿美金的孙正义,如今再次用脚投票,他赌的是:AI的未来,不在于制造铲子的英伟达,而在于定义金矿的OpenAI。

上周 Kimi K2 Thinking 发布,开源模型打败 OpenAI 和 Anthropic,让它社交媒体卷起不小的声浪,网友们都在说它厉害,我们也实测了一波,在智能体、代码和写作能力上确实进步明

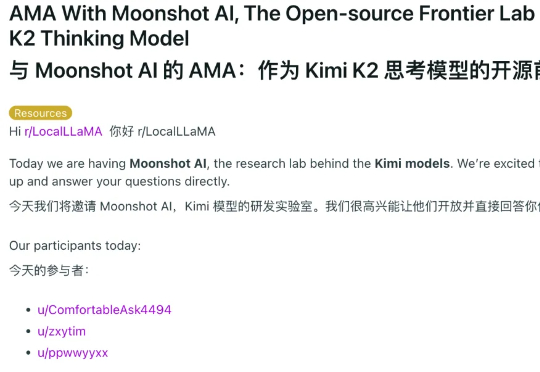

当 agent 开始学会“消费”,支付世界也迎来了重构的时刻。

前段时间,有媒体爆料说 OpenAI 打算推出一个 AI 抖音,没想到隔天,这个「AI 抖音」Sora 就上线了。

就在今天,OpenAI 与 AWS 官宣建立多年的战略合作伙伴关系。OpenAI 将立即并持续获得 AWS 世界级的基础设施支持,以运行其先进的 AI 工作负载。 AWS 将向 OpenAI 提供配备数十万颗芯片的 Amazon EC2 UltraServers(计算服务器),并具备将计算规模扩展至数千万个 CPU 的能力,以支持其先进的生成式 AI 任务

过去一周,我把主流 AI 浏览器都体验了个遍。 OpenAI 的 Atlas、Perplexity 的 Comet、Browser Company 的 Dia,再加上 Edge Copilot,市面上最火的 AI 浏览器,各有各的亮点,也各有各的坑。浏览器的未来长啥样?这些产品给出了完全不同的答案。

尽管今天还有 Sora 角色客串功能和 GPT-5 查找和修复安全漏洞智能体的消息,但本文的重点是深扒 Atlas 背后的「灵魂」—— OWL 架构。看看 OpenAI 究竟是如何驯服 Chromium,把它从浏览器「换皮」玩成了「架构重组」的。